Kunstmatige intelligentie is zo goed geworden in het maken van foto’s en video’s dat AI-beelden bijna niet meer te herkennen zijn. Betekent dit ook dat we al deze beelden voor waar aannemen?

‘We zouden onze mooie Nederlandse tradities, normen en waarden met man en macht moeten verdedigen tegen buitenlandse invloeden.’ Deze tekst is niet van PVV-leider Geert Wilders, maar kwam uit de mond van oud-CDA-fractievoorzitter Sybrand van Haersma Buma in een experiment met deepfakes. Dat zijn AI-video’s waarin mensen dingen zeggen of doen die ze in het echt niet hebben gezegd of gedaan. Van Haersma Buma heeft die zin dan ook nooit uitgesproken.

Toch werd de gemanipuleerde video best geloofwaardig gevonden, zo vertelt Michael Hameleers, een van de onderzoekers die het experiment uitvoerde. Hij is universitair hoofddocent politieke communicatie aan de Universiteit van Amsterdam. “Dat mensen de video redelijk plausibel vonden, verbaasde me wel een beetje. De deepfake was namelijk niet fantastisch. Het was al een paar jaar geleden dat we de video maakten en we hadden ons best gedaan door een acteur voor de stem van Buma in te huren, maar je kon echt wel zien dat de mond niet helemaal goed bewoog en dat de stem eigenlijk ook net niet klopte. Ik had verwacht dat mensen zouden zeggen: leuk geprobeerd, maar dit is natuurlijk nep.”

Sybrand van Haersma Buma tijdens een speech die hij wel heeft gegeven.

European People's Party, CC BY 2.0 via Wikimedia CommonsInmiddels is de techniek toegankelijker en beter geworden. Teresa Weikmann, gepromoveerd op visuele desinformatie aan de Universität Wien en nu werkzaam als postdoc aan de Universiteit van Amsterdam, vertelt dat die toegankelijkheid de reden is waarom we nu zo bezorgd zijn over AI-beeld. “Bedrog met beeld heeft altijd plaats gevonden. Tijdens de Tweede Wereldoorlog zetten de nazi’s al reportages in scène waarin werd gedaan alsof ze vriendelijk waren tegen Joodse mensen. Daar had je toen nog acteurs, camera’s en een hele set voor nodig. De angst is nu vooral dat iedereen achter een computer beelden kan maken die bedriegen, en die beelden zijn ook steeds slechter van echt te onderscheiden.”

Hints

Weikmann legt uit dat er een paar jaar geleden nog adviezen waren over hoe je kon zien dat video’s of foto’s door AI waren gegenereerd. “Bij een video kon je op de mondbewegingen letten, en andere bewegingen in het gezicht zagen er vaak ook raar uit. Maar de techniek is beter geworden en aan dit soort hints heb je nu eigenlijk niet zoveel meer.” En het is de vraag of dit soort adviezen ooit goed hebben gewerkt.

Bennett Kleinberg van Tilburg University onderzocht een paar jaar geleden of tips helpen bij het herkennen van door AI gegenereerde gezichten. Deelnemers aan het onderzoek werd bijvoorbeeld verteld dat bij een AI-gezicht de haarlijn en accessoires, zoals een bril en de stof van de kleding, er vaak gek uitzien. “We hebben eigenlijk helemaal weggegeven waar de fouten van het AI-systeem zaten. Het was dan ook opvallend dat die tips, ook als we ze vaker herhaalden, niet hielpen bij het herkennen van AI-gezichten. Mensen bleven hier erg slecht in. Het was toen al blijkbaar heel ingewikkeld om AI-gegenereerde gezichten van echte te onderscheiden.”

Onterecht wantrouwen

Hameleers waarschuwt dat tips over technische fouten eraan kunnen bijdragen dat mensen beelden ten onrechte wantrouwen. “In echte video’s zien dingen er ook wel eens raar uit, of loopt het geluid niet helemaal synchroon met het beeld.” In het deepfakeonderzoek werden ook authentieke beelden van Van Haersma Buma getoond. “De echte beelden werden niet door iedereen als geloofwaardig gezien. Als mensen de echte beelden wantrouwden, dan dachten ze er soms ook technische foutjes in te zien.”

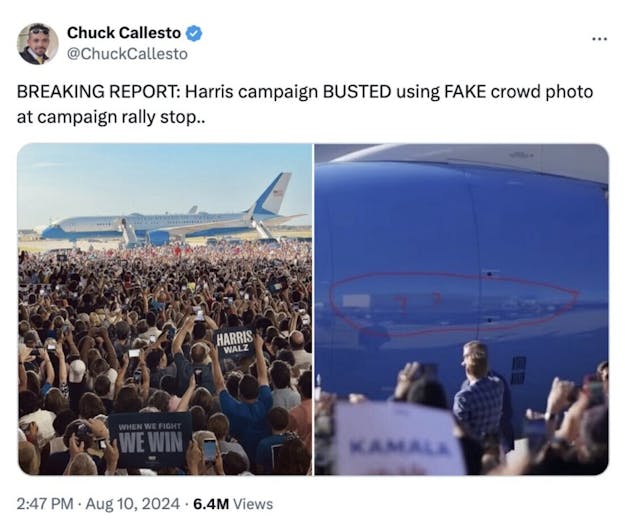

En dit wantrouwen van echt beeld gebeurt vaker. De Amerikaanse presidentskandidaat Donald Trump en zijn aanhangers beweerden bijvoorbeeld dat campagnebeelden van de aankomst van tegenkandidaat Kamala Harris op een vliegveld door AI waren gegenereerd. Op de betwiste foto staat een menigte Harris op te wachten. Volgens Trump-aanhangers was die menigte er helemaal niet en was die gegenereerd met AI. Het vliegtuig heeft geen registratienummer op de staart: bewijs van beeldmanipulatie volgens de Trump-aanhangers.

Het bericht op socialmediaplatform X over de aankomst van Kamala Harris op een vliegveld.

Chuck CallestoFactcheckers van de BBC bewezen dat de menigte op de foto wel degelijk echt is. Dit konden ze doen doordat er heel veel foto’s en video’s van hetzelfde evenement waren, waaronder foto’s en video’s van betrouwbare bronnen. Ook zijn er meerdere beelden van dit vliegtuig op verschillende plekken en tijden zonder registratienummer op de staart. Dat bleek dus geen bewijs voor beeldmanipulatie.

Grens

Hameleers vertelt dat als een foto of video tegen onze bestaande ideeën van de wereld ingaat, we eerder geneigd zijn om beeld als nep te zien. Als je dus gelooft dat er niemand afkomt op de verkiezingscampagne van Kamala Harris, dan zal je het beeld van een grote menigte bij haar aankomst op een vliegveld dus ook veel eerder wantrouwen.

In het deepfake-experiment bleken ook de ideeën die mensen hadden over de politieke overtuigingen van Van Haersma Buma uiteindelijk bepalend of mensen de video’s geloofwaardig vonden of niet. Dit speelde een veel grotere rol dan de technische foutjes. Mensen die de deepfake terecht niet geloofden, zeiden: ‘Dit is niet is wat ik met deze persoon associeer of herken als zijn denkbeeld’, aldus Hameleers. Hoe extremer de woorden waren die de onderzoekers Buma in de mond legden, hoe minder geloofwaardig de video werd gevonden. “Dat vond ik ook wel een mooie uitkomst. Er wordt wel eens gezegd dat je mensen met deze technieken alles kan laten geloven, maar daar zit toch een grens aan.”

In de echte wereld

“Mijn belangrijkste tip om beter te worden in het herkennen van AI-beeld, is dan ook om jezelf af te vragen of het beeld wel klopt met wat je weet”, aldus Hameleers. “Als het mogelijk om een deepfake gaat, stel jezelf de vraag of de video overeenkomt met het beeld dat je van deze persoon hebt: heeft diegene eerder iets gezegd of gedaan wat hierop lijkt? Kijk daarnaast ook naar de bron van het beeld: welke doelen heeft iemand met het sturen van de beelden? Is het echt om te informeren of om je een kant op te sturen? Zekerheid over of een beeld echt of nep is, geeft dit nog niet, maar het helpt wel. De technieken worden beter, maar het doel blijft hetzelfde, namelijk om iets te laten zien wat in de echte wereld niet is gebeurd.”

— Teresa Weikmann

Weikmann vult aan dat als je meer informatie wilt over een beeld dat je wantrouwt, je kan kijken of het beeld al door betrouwbare factcheckers is onderzocht, zoals Nieuwscheckers, Knack of VRT NWS. “Als dat nog niet zo is, kan je factcheckers het beeld ook mailen. Voor meer context kan je ook een reverse image search-tool, zoals Google Lens, gebruiken. Daarmee kan je zien waar een afbeelding nog meer op het internet voorkomt. Je kan dan zien hoe oud de foto ongeveer is en wie het beeld voor het eerst online heeft geplaatst.”

“Factcheckers onderzoeken ook of het beeld dat ze wantrouwen overeenkomt met hoe de echte wereld eruitziet”, vertelt Weikmann. “Als wordt beweerd dat een foto op een bepaalde plek is genomen, kijken ze of dit plek er ook echt zo uitziet. Dit kan bijvoorbeeld met satellietbeelden op Google Earth. Op deze manier beeld checken levert je misschien nog geen zekerheid op, maar het kan wel helpen.”

Verkeerd gedacht

Soms lijkt iets zo logisch, dat ons brein geneigd is te kort door de bocht te gaan. In de serie ‘Verkeerd gedacht’ staan we stil bij enkele veelvoorkomende denkfouten. Hoe komt het dat we daar zo vatbaar voor zijn? En hoe kun je er weerstand tegen bieden?