Software voor gezichtsherkenning die jouw gezicht niet eens ziet? Dat klinkt bizar, maar het overkwam Joy Buolamwini. De film ‘Coded Bias’ volgt haar strijd tegen discriminatie door algoritmen.

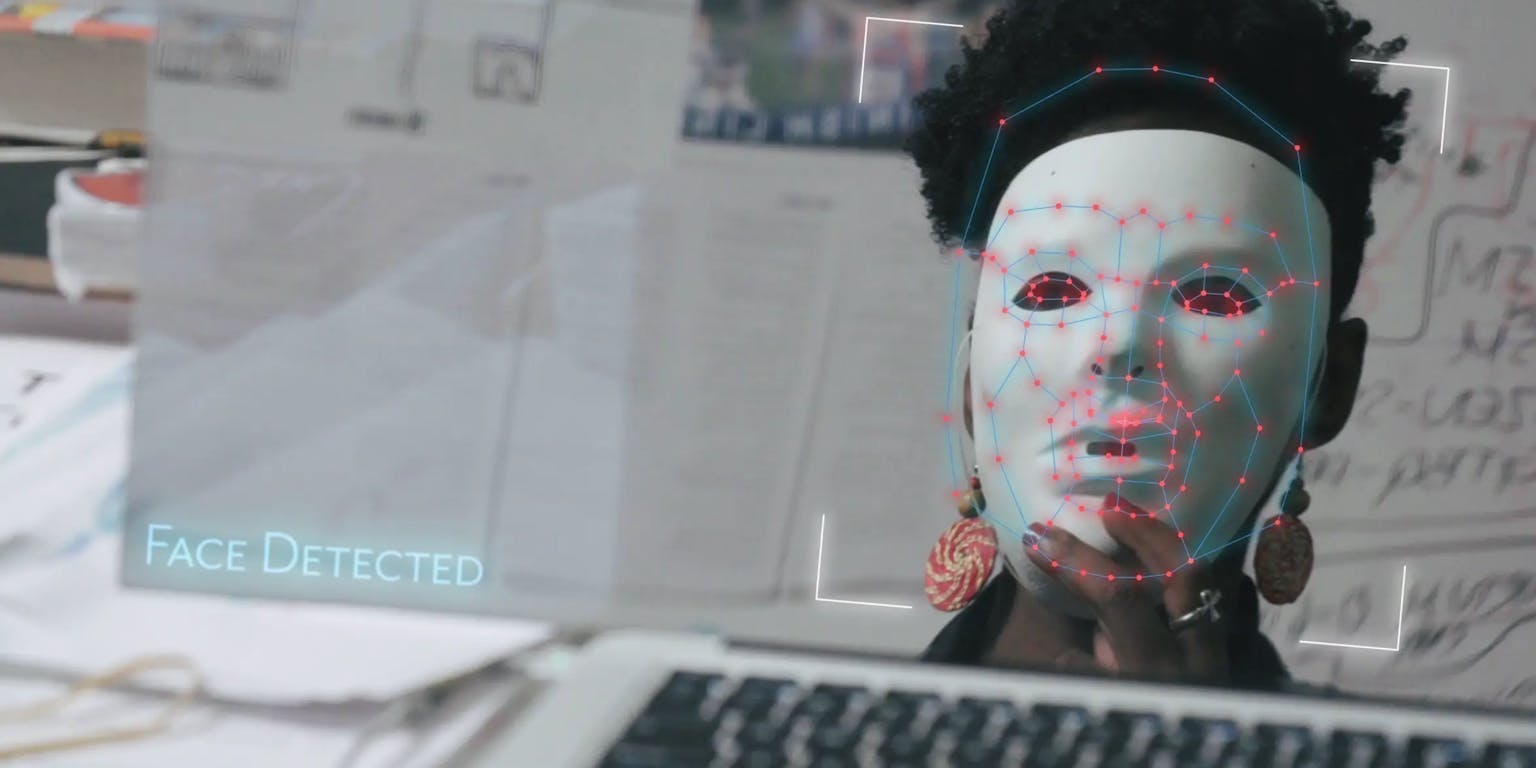

Als de Amerikaanse Joy Buolamwini, onderzoeker bij het MIT Media Lab, voor een project aan de slag gaat met gezichtsherkenningsoftware gebeurt er iets vreemds: haar gezicht wordt niet gezien door de software. Ze probeert van alles, maar pas als ze een wit masker opzet – Buolamwini heeft een donkere huid – is het raak. Het systeem ziet nu wel een gezicht. Buolamwini gaat de software van verschillende grote bedrijven testen en de resultaten zijn glashelder: de gezichten van mannen worden veel beter herkend dan die van vrouwen en hoe donkerder je huid, hoe slechter de gezichtsherkenning scoort. De verschillen tussen groepen zijn groot.

Dat heeft enorme gevolgen, want gezichtsherkenning wordt steeds meer gebruikt door bedrijven en overheden. Als jouw gezicht niet goed kan worden beoordeeld door zo’n systeem, is de kans op misidentificatie heel groot. Voor je het weet word je ten onrechte aangezien voor, bijvoorbeeld, een gezochte crimineel. En als zo’n systeem meer moeite heeft met een donkere huid dan met een lichte, heb je dus als persoon van kleur een grotere kans om voor iemand anders te worden aangezien. Kortom, zo’n systeem is bevooroordeeld en leidt tot discriminatie. In vaktermen: het bevat een een ‘bias’.

Buolamwini laat het er niet bij zitten. Ze publiceert haar resultaten, benadert bedrijven die gezichtsherkenningsoftware maken en ze zoekt de publiciteit. In de film ‘Coded Bias’ volgen we Buolamwini vanaf haar eerste ontdekking tot haar deelname aan een hoorzitting in het Amerikaanse congres over discriminatie door algoritmen. Een van haar belangrijkste punten: de vooroordelen zijn, wellicht onbewust, geprogrammeerd doordat verreweg de meeste programmeurs en softwareontwikkelaars ‘pale males’ zijn – mannen met een lichte huid. Als trainingsmateriaal voor hun algoritmen gebruiken zij voornamelijk foto’s van andere ‘pale males’. Met als resultaat een systeem dat heel goed heeft geleerd om witte mannen te herkennen, maar moeite heeft met iedereen die dat niet is.

Trailer van Coded Bias

Computerwetenschapper Mykola Pechenizkiy is hoogleraar Data Mining aan de Technische Universiteit Eindhoven en zijn onderzoek richt zich onder meer op discriminatie en bias in algoritmen. Op verzoek van NEMO Kennislink bekeek hij ‘Coded Bias’. De film wordt online vertoond tijdens het InScience filmfestival, dat loopt van 11 tot en met 22 november.

Wat vond je van de film? Herken je problemen die aan bod komen?

“Ik ben heel blij dat algoritmen en breder, het hele AI-veld (Artificial Intelligence, ofwel kunstmatige intelligentie, red.) steeds meer een belangrijk onderwerp wordt voor iedereen buiten de wetenschap en de wereld van ontwikkelaars. Deze film is ook gemaakt voor een breed publiek en geeft op veel fronten een realistisch beeld. Het is af en toe erg gesimplificeerd, maar daar ontkom je bijna niet aan. Wat ik ook belangrijk vind is dat de film niet anti-technologie is. Technologie kun je voor goede en slechte doeleinden gebruiken, maar die keuze ligt bij mensen. Daarom is het belangrijk om onderscheid te maken tussen bewust misbruik van een technologie en ongewenste effecten doordat we nog niet alles goed begrijpen. Nu we steeds meer zicht krijgen op die ongewenste effecten door het al dan niet onverantwoordelijke gebruik van AI, kunnen wetenschappers en gebruikers bijdragen aan de ontwikkeling van nieuwe, verantwoordelijke AI. “

De film hinkt wel op twee gedachten. Enerzijds is er de kwestie van discriminatie doordat algoritmen selectief zijn getraind. Anderzijds zien we verschillende problemen ontstaan door het gebruik van gezichtsherkenning, maar ook door uiteenlopende voorspellende algoritmen, bijvoorbeeld om te bepalen wie voorrang krijgt in de zorg of wie wordt uitgenodigd voor een sollicitatiegesprek.

“Klopt. Veel van de problemen die we hebben met AI zijn niet per se technische problemen, maar hebben vaak een sociale, maatschappelijke en juridische kant. Natuurlijk moet je zorgen dat de systemen die je gebruikt niet discrimineren en geen schadelijke gevolgen hebben voor mensen, maar zelfs als je perfect betrouwbare en eerlijke systemen hebt, is er nog de vraag of je ze überhaupt voor van alles wilt gebruiken. Dat laatste is een vraag die je niet alleen vanuit de techniek kan beantwoorden.”

&t=637s

Maar hoe kon dit gebeuren? Je zou toch verwachten dat de mensen die zelflerende algoritmen ontwikkelen weten dat de gegevens die je kiest om het systeem te trainen invloed hebben op hoe het systeem uiteindelijk functioneert?

“Wat zeker meespeelt is dat dit nog allemaal heel nieuwe ontwikkelingen zijn. Eigenlijk zetten we pas net de eerste stappen. Bovendien zijn de eerste successen geboekt in toepassingen waarbij de ongewenste uitkomsten niet veel impact hadden. Deze algoritmen zijn onder meer snel toegepast in zoekmachines om suggesties te doen over bijvoorbeeld een film die je waarschijnlijk leuk vindt op basis van je zoekgedrag. In het ergste geval vind je die film helemaal niks. Dat valt allemaal reuze mee natuurlijk.”

“Maar meer en meer zijn we voorspellende algoritmen gaan inzetten om op allerlei andere gebieden koppelingen te maken. Zoals om te selecteren bij sollicitaties of te bepalen wie een lening krijgt. Dan kunnen de gevolgen wel heel ernstig zijn. Tegelijkertijd leeft de verwachting dat AI bovenmenselijke prestaties levert en hebben we onvoldoende veiligheidscontroles ingebouwd. Die moeten er wel komen, want we weten dat als je niet goed oplet en actief probeert een bias te voorkomen, dit gaat gebeuren.”

Hoe komt dat?

“Voorspellende algoritmen zoeken naar patronen, dat is ook wat we willen en waar we ze op trainen. Een vooroordeel is ook een patroon, maar dat willen we niet. Vandaar de uitdrukking ‘bias in, bias out’. Daarom moet je goed kijken naar wat gewenste en ongewenste patronen zijn. Het probleem zit dus niet alleen in een bias in de data die je gebruikt, maar ook in de manier waarop het algoritme patronen opspoort en herkent. AI-systemen kunnen oneerlijke beslissingen nemen doordat, soms onbewust, geen rekening wordt gehouden met criteria voor eerlijkheid bij het ontwerp en de manier waarop het systeem wordt ingezet. Je moet je goed afvragen welke criteria een systeem gebruikt voor optimalisatie. Welke kenmerken zijn meegenomen en welke niet bij het modelleren en waarom zijn die keuzes gemaakt? Hoe is het probleem dat AI moet oplossen precies gedefinieerd, wat is het ‘frame’? Stel je wilt een AI-systeem dat het risico op crimineel gedrag voorspelt om zo beslissingen over voorwaardelijke vrijlating te nemen. Omdat we geen gegevens hebben over wie misdrijven pleegt, maar wel van mensen die zijn gearresteerd, gebruiken we die gegevens als een ‘proxy’, een voorspellend kenmerk. Maar zo’n proxy is niet accuraat. Oversimplificatie is gevaarlijk.”

Negatieve gevolgen van nieuwe technologie worden vaak pas duidelijk als die grootschalig wordt toegepast. Is het wel mogelijk om te voorspellen wat de effecten van een nieuwe technologie zijn?

“Nou, wij zijn juist veel bezig om een beeld van de toekomst te vormen. De bewustwording rond de ethische aspecten van AI neemt snel toe en het is echt een hot topic in het veld. Dat is snel gegaan. De TUE was tien jaar geleden een van de voorlopers op dit onderwerp en destijds was het heel lastig om onderzoek naar bias gepubliceerd te krijgen. Dat werd niet als een serieus onderwerp gezien. Nu staat het op alle grote conferenties op het programma. Tegelijkertijd is het belangrijk om te beseffen dat het AI-veld niet alle ethische vraagstukken kan oplossen.”

Waar zit het probleem voor jullie?

“Veel van de problemen komen uiteindelijk neer op de vraag naar onze gedeelde waarden en hoe we die kunnen formaliseren, dus omzetten in goed gedefinieerde, meetbare criteria. Wat vinden we ‘eerlijk’ en ‘rechtvaardig’? Dat zijn geen vragen die ontwikkelaars en programmeurs alleen kunnen beantwoorden, daarvoor hebben we samenwerking nodig met de sociale wetenschappen, met juristen, filosofen en ethici. We hebben interdisciplinair onderzoek nodig en dat krijgt ook vorm, maar dat kost tijd. Er is een grote kloof tussen al die gebieden en we begrijpen elkaar nog niet altijd.”

Waar richt jouw onderzoek zich nu op?

“Wij onderzoeken hoe je betrouwbare, ethisch verantwoorde en eerlijke AI ontwikkelt en die ook goed uit te leggen is. Daarnaast werken we aan methoden om AI-systemen te evalueren en beoordelen. Als je AI wilt gebruiken voor het selecteren van sollicitanten of voor het bepalen wie een lening krijgt, dan zou het goed zijn als er een onafhankelijke manier is om te testen of het systeem het gewenste gedrag vertoont. Denk aan een soort certificering door een derde partij. Daar moeten we echt naartoe. Ik ben het eens met de stelling dat AI de elektriciteit van de 21e eeuw is. Dat vereist echter wel dat we het goed begrijpen, zodat we het ook ten goede inzetten.”